Beberapa waktu lalu Microsoft secara resmi meluncurkan Maia 200, sebuah akselerator AI buatan (in-house) generasi kedua yang difokuskan untuk beban kerja inference.

Nah pengumuman ini menandai lompatan yang sangat signifikan dalam strategi silicon mandiri Microsoft, sekaligus tantangan langsung kepada pesaing utama seperti Google dan Amazon dalam hal komputasi Cloud AI.

Berdasarkan pengumumannya, Maia 200 ini dibangun di atas fondasi dari Maia 100, yang perbedaan utamanya terletak pada teknologi proses dan efisiensi yang dihasilkan, Maia 100 menggunakan proses 5nm TSMC, sementara Maia 200 telah beralih ke proses 3nm TSMC yang lebih baru, yang memungkinkan peningkatan kerapatan transistor dan efisiensi daya yang lebih baik.

Dari sisi spesifikasi, Maia 200 ini cukup mengesankan juga loh, di mana dia sudah mendukung 216GB HBM3e dengan bandwidth mencapai 7 TB/s, On-chip SRAM 272MB untuk mempercepat akses data, Tensor core native mendukung FP8 dan FP4 secara native, dan dilengkapi Network-on-Chip (NoC) terintegrasi dengan bandwidth bidirectional 2.8 TB/s, memungkinkan komunikasi super cepat dalam kluster besar hingga 6.144 akselerator.

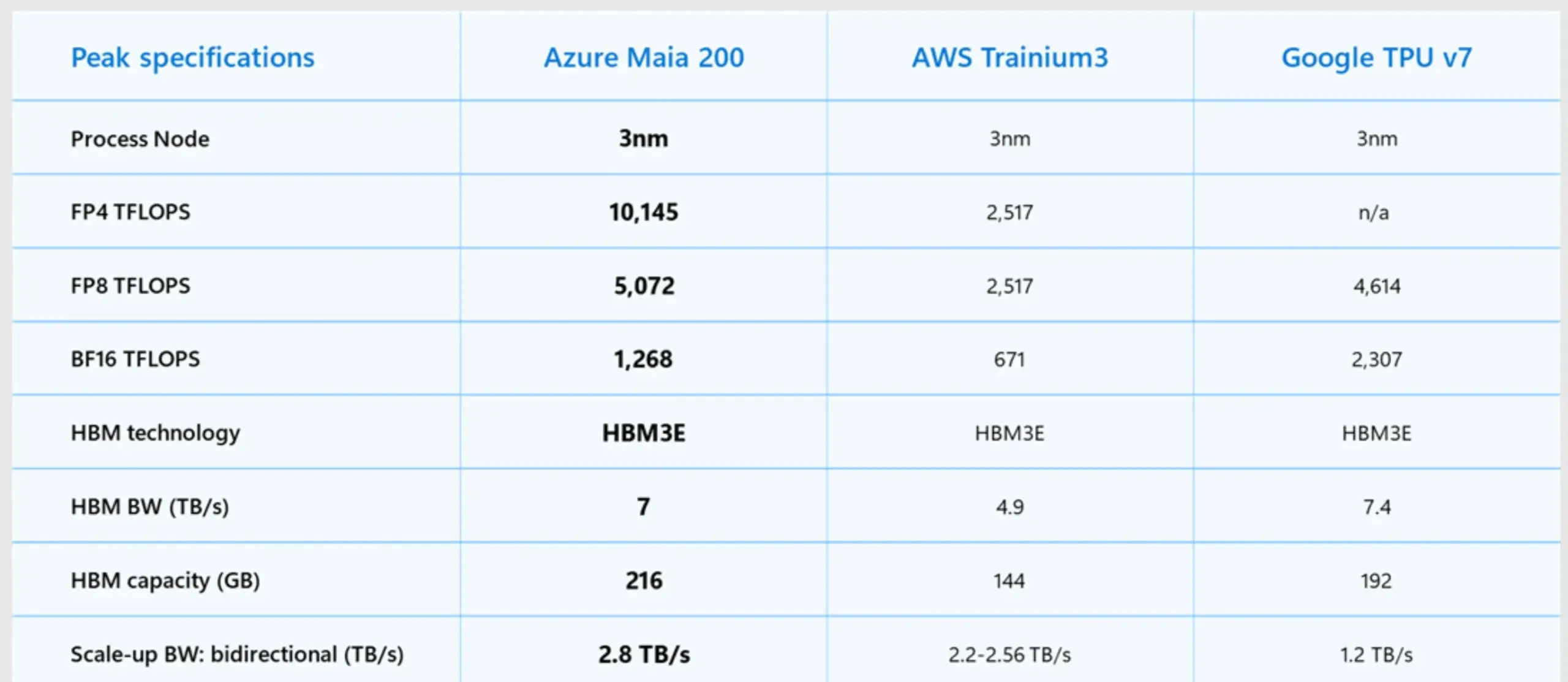

Microsoft secara terbuka juga mempublikasikan tabel perbandingan yang menempatkan Maia 200 ini langsung dengan chip pesaing yang tabelnya bisa kamu cek pada gambar berikut.

Nah berdasaran data tabel yang dirilis tersebut, Maia 200 menghasilkan kinerja FP8 hampir dua kali lipat dari akselerator generasi ketiga Amazon Trainium, dan sekitar 10% lebih tinggi daripada TPU generasi ketujuh Google. Tentunya, klaim performa ini menunjukkan kepercayaan diri Microsoft bahwa mereka tidak hanya mengejar, namun juga telah melampaui para pelopor di bidang silicon khusus AI.

Baca Juga : OpenAI Rilis Prism: Ruang Kerja Berbasis GPT-5.2 untuk Kolaborasi Ilmiah

Lebih Efisien Dalam Biaya!

Selain performa yang jauh lebih baik, dalam pengumumannya, Microsoft menekankan aspek efisiensi bisnis Maia 200, di mana mereka mengklaim bahwa akselerator baru ini menawarkan performa per dolar 30% lebih baik dibandingkan perangkat keras generasi terbaru yang saat ini digunakan di Azure.

Baca Juga : Google Chrome Uji Fitur Baru yang Berpotensi Memperlambat Booting Windows 11/10

Selain itu, menariknya, berbeda dengan Maia 100 yang dulu diumumkan jauh sebelum penerapan-nya, Maia 200 ini sudh diterapkan dan sudah beroperasi, bahkan kabarnya Chip ini telah di-deploy di wilayah pusat data Microsoft US Central (dekat Des Moines, Iowa) dan US West 3 (dekat Phoenix, Arizona), menunjukkan kematangan desain dan kesiapan produksi.

Untuk menyuplai infrastruktur ini, bahkan Microsoft baru baru ini telah bekerjasama dengan SK Hynix untuk supply RAM ekslusif yang artikelnya bisa kamu baca pada halaman : Microsoft Dan SK Hynix Kerjasama Untuk Supply RAM Eksklusif

Nah secara umum, Peluncuran Maia 200 bukan sekadar pembaruan produk saja, namun juga ini pernyataan strategis dari Microsoft bahwa mereka serius dalam mengembangkan solusi silicon mandiri yang tidak hanya hemat biaya, namun juga mampu bersaing langsung dengan yang terbaik yang di industri saat ini.

Bagaimana menurutmu? komen dibawah guys.

Via : Microsoft

Catatan Penulis : WinPoin sepenuhnya bergantung pada iklan untuk tetap hidup dan menyajikan konten teknologi berkualitas secara gratis — jadi jika kamu menikmati artikel dan panduan di situs ini, mohon whitelist halaman ini di AdBlock kamu sebagai bentuk dukungan agar kami bisa terus berkembang dan berbagi insight untuk pengguna Indonesia. Kamu juga bisa mendukung kami secara langsung melalui dukungan di Saweria. Terima kasih.