Microsoft baru baru ini kembali menghadirkan inobasi dalam dunia AI dimana mereka telah merilis Phi-4-mini-flash-reasoning, sebuah SLM atau small language model yang dirancang untuk penalaran cepat dan efisien dengan footprint rendah.

Berbeda dengan model lama, model ini dioptimalkan untuk kebutuhan inference di perangkat dengan sumber daya terbatas seperti edge devices dan aplikasi mobile.

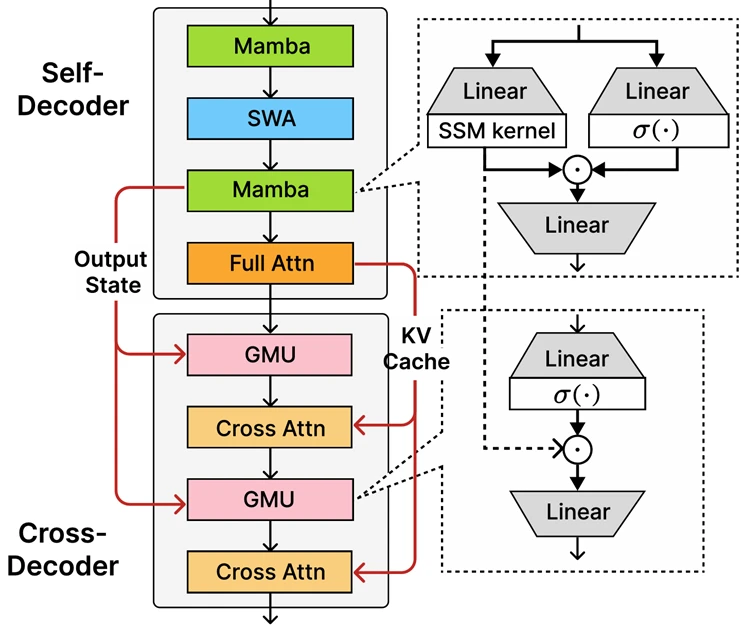

Model ini sendiri kabarnya dibangun di atas arsitektur decoder-hybrid-decoder bernama SambaY yang menggabungkan beberapa teknologi seperti Gated Memory Unit (GMU) untuk efisiensi representasi antar-layer, lalu sliding window attention (SWA) dan State Space Models berbasis Mamba yang mendukung reasoning dalam konteks luas dan panjang tanpa kehilangan performa. Selain itu elemen prefill linear juga memberikan peningkatan througput secara signifikan dengan mengurangi bottlenect pada langkah awal inferensi.

Secara teori, ini akan menghasilkan throughput 10 kali lebih tinggi dan latensi 2–3 kali lebih rendah dibanding pendahulunya, dan kabarnya nih guys, meski hanya berukuran 3.8B, model ini melampaui ekspektasi dengan performa reasoning yang superior: Pass@1 di benchmark Math500 mencapai 92.45%, dan hasil di AIME24/25 bahkan melampaui model lain yang berukuran lebih dari dua kali lipat, ini sih udah mantap banget ya.

Selain itu, karena adanya optimisasi pada framework vLLM, ini akan memungkinkan model ini berjalan lancar bahkan hanya pada satu unit GPU A100, yang jelas akan membuatnya menjadi sebuah pilihan ideal untuk deployment skala kecil maupun eksperimen edge devices.

Microsoft meyakini bahwa model terbaru ini akan sangat bermanfaat untuk sejumlah segmen berikut:

- Pembelajaran adaptif yang membutuhkan umpan balik instan.

- Agen penalaran yang berjalan langsung di perangkat, seperti tutorial mobile.

- Sistem pembelajaran interaktif yang secara dinamis menyesuaikan tingkat kompleksitas konten berdasarkan performa siswa

Nah untuk sekarang, Phi-4 mini-flash-reasoning model sudah tersedia untuk developer di Azure AI Foundry, Nvidia API Catalog dan Hugging Face.

Bagaimana menurutmu? komen dibawah guys.

Via : Microsoft

Catatan Penulis : WinPoin sepenuhnya bergantung pada iklan untuk tetap hidup dan menyajikan konten teknologi berkualitas secara gratis — jadi jika kamu menikmati artikel dan panduan di situs ini, mohon whitelist halaman ini di AdBlock kamu sebagai bentuk dukungan agar kami bisa terus berkembang dan berbagi insight untuk pengguna Indonesia. Kamu juga bisa mendukung kami secara langsung melalui dukungan di Saweria. Terima kasih.